par Benoît Rittaud.

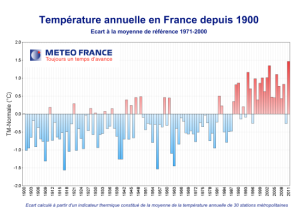

L’une des séries de données que j’ai réclamées à Météo France est celle des anomalies annuelles de température en France, qui correspondent à ce graphique.

Lorsque j’ai découvert, et donc signalé à Météo France, que ces données qu’elle me refusait étaient en réalité en accès libre sur le site de l’IPSL, il m’a été répondu notamment ceci :

les données du fichier excel du site cycleducarbone.ipsl.jussieu.fr semblent présenter une ou plusieurs anomalies. L’année 2009 aurait pour valeur de l’indicateur 11.1. La normale de température pour les 30 dernières années est de 12.6 (source MF).

(…)

Le site de Jussieu précise que « les captures d’écran de cette page représentent des données s’arrêtant en 2008 ». Le fichier excel n’a peut être pas été mis à jour comme il est précisé. Pour toutes les années antérieures il y a cohérence.

La phrase importante est la dernière : « pour toutes les années antérieures [à 2008] il y a cohérence. » Il est légitime de supposer que mon correspondant a comparé le fichier Excel de l’IPSL avec celui de Météo France et qu’il a vérifié que les deux coïncidaient jusqu’en 2008. En attendant que MF daigne me donner le fichier (j’attends toujours) ou que la CADA l’enjoigne de le faire, ce courrier de Météo France affirme à l’évidence qu’on peut utiliser le fichier de l’IPSL en confiance avant 2008. (Je traiterai dans un autre article le cas des années plus récentes.)

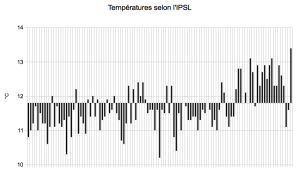

N’étant pas tout à fait un perdreau de l’année, j’ai quand même voulu vérifier que le fichier de l’IPSL donnait bien le même graphique que celui publié par Météo France jusqu’en 2008. J’ai donc tracé le graphique suivant, constitué des données du fichier de l’IPSL normalisées un peu comme j’ai pu.

Je profite de l’occasion pour dire tout le mal que je pense de la forme donnée au graphique de MF (et par ricochet le graphique ci-dessus, conçu pur lui ressembler), qui accorde une importance privilégiée à une « valeur normale » pourtant purement conventionnelle et force l’œil à ne lire le graphique que par rapport à cette référence, ce qui pollue considérablement l’environnement visuel de la courbe. Passons.

Deux points doivent être notés avant toute tentative de comparaison :

1) l’IPSL donne des températures absolues là où Météo France donne des écarts à une température de référence. Il y a donc une soustraction à faire. Ça n’a rien de difficile, sauf que la valeur à soustraire n’est probablement pas la normale de 12,6°C prise par Météo France. (Ç’aurait été trop beau.) Conséquence : il ne faut pas attacher trop d’importance à une éventuelle différence qualitative du genre « chez l’IPSL l’année n est au-dessus de la moyenne alors qu’elle est en-dessous chez MF ».

2) l’IPSL donne des températures au dixième de degré près, alors que le graphique de Météo France est manifestement constitué de données plus précises, probablement au centième près. (Voyez par exemple, dans le graphique de Météo France, les années 2004 et 2005 : les valeurs correspondantes sont distinctes mais, selon l’échelle des ordonnées, leur différence est nettement inférieure à 0,1°C ; selon ma propre mesure, elle est voisine de 0,01°C : cf. ci-dessous.) De petits écarts entre les deux fichiers sont donc inévitables et pas forcément significatifs.

Une fois formulées ces réserves importantes, voici une superposition des deux diagrammes.

Même en tenant compte des points 1 et 2, la comparaison ressemble à un jeu des 7 erreurs. Pour en avoir le cœur net, je me suis donc lancé dans ce que j’espérais pouvoir éviter de faire : évaluer à la main chacune des valeurs du graphique de MF. Pour ceux que cela intéresse, j’ai mis les résultats dans un fichier que vous pouvez télécharger (ReconstitutionGraphiqueMF). La mesure « à la main » a été un peu longuette, mais pas difficile. Avec un logiciel de géométrie (GeoGebra), j’ai placé en tant qu’image le graphique de MF sur une fenêtre et j’ai, pour chaque année n, mesuré la distance (normalisée, j’espère convenablement) entre l’origine du repère et la droite horizontale passant par le bout du bâton de l’année n. Ci-dessous les exemples superposés des années 2004 et 2005, dont la distance évaluée à 0,01°C indique qu’il n’y a pas besoin d’un œil de lynx pour espérer une précision de l’ordre du centième de degré, même s’il faut bien sûr rester prudent dans l’interprétation de données obtenues d’une telle manière.

Une fois effectué cet ingrat travail de mesure (pour lequel je devrais peut-être envoyer la facture à MF…), j’ai superposé le graphique qui s’en déduit de celui de MF pour voir si je n’avais pas fait un trop mauvais boulot. Voici :

Mon vieux Ben, c’est bon : t’as pas encore besoin de prendre rendez-vous chez l’ophtalmo.

Une fois les valeurs du graphique de MF connues, on peut évaluer les écarts avec les données de l’IPSL. C’est là qu’il faut choisir une valeur normale de référence à soustraire (point 1 ci-dessus). Sans pouvoir garantir l’exactitude de mon choix, il me semble que la valeur de 11,7°C ne doit pas être loin de la vérité. Voici un graphique qui présente, avec cette valeur, la différence entre les anomalies de l’IPSL et celle de MF. Comme vous le voyez, c’est une jolie crosse de hockey qui apparaît.

Le problème vient de l’année 2009, et il faut reconnaître que MF m’avait prévenu.

Deuxième tentative, en arrêtant le graphique juste avant cette année mystérieuse :

Même dans un monde idéal où le fichier de l’IPSL correspondrait à celui de MF, le fait que l’IPSL ait arrondi à un seul chiffre après la virgule fait que la courbe ne pouvait pas être parfaitement horizontale et située à la hauteur zéro : il y aurait forcément eu quelques fluctuation dues aux arrondis. Sauf que ces fluctuations ne peuvent normalement pas sortir d’un intervalle de taille 0,1°C. Par exemple, si, comme il est le plus logique, les arrondis de l’IPSL ont été faits au plus proche dixième (en arrondissant 0,43°C à 0,4°C et 0,47°C à 0,5°C, par exemple), alors la courbe ci-dessus devrait rester à l’intérieure d’une bande horizontale limitée par les valeurs -0,05 et +0,05. Pour tenir compte des imprécisions dans mes mesures, on peut pousser jusqu’à -0,06 et +0,06, mais pas plus. Chaque écart dépassant 0,06 (en plus ou en moins) correspond donc à une année pour laquelle l’IPSL et MF divergent. Cela se produit dans 28 cas. Sur 111 années, cela fait tout de même un taux d’erreur de 25 %.

Si c’est cela que Météo France considère comme des données « en cohérence », alors nous n’avons pas la même définition du mot.

Précisons que cette divergence reste qualitativement le même lorsqu’on change la valeur de référence (11,7°C), c’est-à-dire, de manière équivalente, qu’on fait glisser la bande horizontale autorisée vers le haut ou vers le bas (en pratique, ce qui est gagné d’un côté est perdu de l’autre).

Enfin, j’ignore s’il faut chercher une tendance quelconque dans cette courbe des écarts entre MF et l’IPSL. Le fait que les données de MF soient homogénéisées à partir de 1947 a-t-il quelque chose à voir avec le décrochage particulièrement brusque qui se produit au début des années 1950 ? Coïncidence, peut-être.

À suivre…

Bravo pour la clarté des explications quoiqu’un peu techniques pour le grand public. Mais il me semble qu’on ne s’attarde pas assez au fond du problème, à savoir la pertinence de ces mesures de températures.

En tant que modeste physicien de formation je me suis toujours interrogé sur l’utilité de ces séries longues, dans le temps et l’espace pour décrire un système dynamique.

Que décrivent-t-elles ? Quelle équation de conservation utiliser ?

A ma connaissance il n’y a pas d’utilisation de ces moyennes en physique.

Elles n’auraient donc qu’une signification statistique…

et pourtant je pense qu’elles ne représentent que du bruit.

Ce sont des courbes au centième, les thermomètres sont loin d’une telle précision ; on ne voit rien d’autre qu’un point qui gigote dans une barre d’erreur.

Contrairement à certains sceptiques, je ne suis même pas convaincu qu’on puisse, avec ces variations d’un dixième de degré sur des décennies, conclure que la « terre se réchauffe ».

La seule chose que l’on peut affirmer à la vue de ces courbes, c’est que la température de la planète est remarquablement stable depuis un bon moment.

J’imagine qu’il est facile d’interpréter physiquement un bruit blanc comme ça vous arrange, mais si en plus on est malhonnête comme le montrent ces bidouillages de MF…

Au fait, n’y-a-t-il pas des outil de traitement du signal (autocorrélation ou aures ?) pour démontrer le caractère aléatoire d’une série ?

Je profite de la présentation du graphique des températures annuelles en France pour rappeler qu’il est annoncé que l’année 2014 va être proche des records de chaleur depuis 1880.

Si l’on se réfère au graphique, on devrait donc avoir une température supérieure de 1,5 à 2°C supérieure à la moyenne d’avant 1970, écart considéré comme source de grands dangers.

Or quelles sont les conséquences de cette augmentation record de températures.

Récolte de blé abondante

http://www.terre-net.fr/observ.....03174.html

récolte à la hausse des vendanges

http://www.vitisphere.com/them.....-2014.html

Nappes phréatiques normales ou supérieures à la normale

http://www.brgm.fr/presse/etat.....embre-2014

Très bon enneigement dans les stations de ski

http://www.meteofrance.fr/clim.....s-francais

Pollution inférieure aux normes admises

http://www.airparif.asso.fr/et.....&y=15

Aucun problème sanitaire

On nous annonçait des problèmes d’eau, de récoltes, d’enneigement, de pollution et des problèmes sanitaires.

On ne peut donc que constater qu’une augmentation de 1,5 à 2° n’a strictement aucun effet sur les points considérés comme particulièrement sensibles.

A partir de ce constat, on peut conclure que soit les données de température sont fausses, soit les effets prévus d’une hausse de température sont faux.

On ne sait pas si les donnée de l’IPSL pour la France sont les données de MF.

Ce ne sont peut-être qu’un sous-ensemble de leur fichier pour le monde :

hadcrut3 ?

Nicias (#3),

Nicias (#3), le fichier « tempfrance1901-2011.xls » de l’IPSL précise explicitement :

De plus, le graphique en bâton au-dessus (et à gauche) du lien vers ce fichier est le même (à d’intéressantes nuances de forme près) que celui du Bilan climatique 2011 de MF.

chercheur (#2),

A votre liste de conséquences bénéfiques de cette année « chaude », on peut ajouter les conditions exceptionnellement bonnes en haute montagne pour un bon nombre d’itinéraires d’alpinisme de haut niveau comme en face nord des grandes jorasses notamment.

Pour le plus grand bonheur des forts alpinistes qui s’y sont bousculés ! Voir par exemple ce blog.

J’attends aussi le bilan de masse du glacier blanc dans le massif des écrins qui devrait bientôt être donné par le parc national des écrins. Au vu de l’été pourri, il devrait être proche de l’équilibre malgré une accumulation hiverno/printanière relativement faible.

En ce qui concerne les statistiques de température, j’ai découvert récemment ce site qui n’est pas inintéressant: observatoire savoyard du changement climatique

J’ai bien aimé le graphique suivant présenté dans le dernier bilan climatique, Ca colle pas mal avec ce que Courtillot avait constaté: un brusque saut des t° dans les années 80 mais pas d’augmentation continue:

Pour le grand public, l’équation est simple :

Plus il fait chaud et plus la température est élevée et plus la moyenne des températures (!) est élevée.

À partir de là, tous les artifices (erreurs) qui amplifient le niveau de la température sont utilisés. Est-ce pertinent de faire des moyennes et des stats de température?

Pour un physicien, je ne le pense vraiment pas, mais pour les autres personnes sans attrait particulier pour la physique, c’est le meilleur moyen de savoir s’il y a un réchauffement.

C’est là le problème.

Pour faire un lien avec le bistrot , c’est vrai que la climatologie et l’économie ont des ressemblances dans la manipulation des statistiques.

Bob (#4), N’oublions pas que dans climategate toute la « fine fleur » francaise est a la manoeuvre, Legras et surtout l’impayable Bard… qui fait bien rire les britanniques d’ailleurs et qu’il faut « proteger ».

Ben (#5),

Oui mais dans tous les cas ce sont des données brutes de MF. Reste à savoir si la technique d’homogénéisation est la même.

Le plus curieux, c’est la différence de 1°C dans les valeurs absolues. Les modèles sont notoirement plus froid que les températures réelles, et on est dans le bon ordre de grandeur. Le modèle de l’IPSL je crois fait partie du podium en terme de réchauffement passé et à venir, il doit avoir une moyenne particulièrement basse de départ.

Bernnard (#8),

Pour faire un lien avec le bistrot , c’est vrai que la climatologie et l’économie ont des ressemblances dans la manipulation des statistiques.

Ah non, on est nettement plus doués que les climatologues !

Mais laissons cela pour le bistrot

Ben (#5),

Sources : IFEN/MétéoFrance

IFEN : Il a été « dissous par un décret publié au journal officiel le 29 novembre 2008 » et remplacé par un nouveau Service de l'observation et des statistiques (SOeS) chargé de collecter et mettre en forme la statistique sur les thèmes « du logement et de la construction, des transports, de l'énergie et du climat, de l’environnement, du développement durable », au sein du Commissariat général au développement durable du ministère de l'écologie.

Au cas ou, vous avez un nouvel organisme pour adresser vos requêtes.

Hug (#7),

Je n’ai pas pu retrouver le graphique sur le site que vous avez indiqué.

Quoiqu’il en soit ce graphique est très intéressant. 64 ans d’historique, un plateau pendant 38 ans, une hausse de 2° en deux ans et après un plateau de 24 ans.

Que s’est-il passé entre 1988 et 1990? On a installé un grand radiateur qui fonctionne depuis cette date ou c’est à partir de cette date que les données ont été manipulées?

Ce qui est sûr, c’est que ce n’est pas grâce à ce graphique que l’on peut justifier la fonte continue des glaciers et encore moins un réchauffement provoqué par une hausse de CO2.

A la réflexion, ce graphique est peut-être d’une importance considérable pour démontrer l’aberration de tout ce qui nous est raconté.

chercheur (#12),

J’ai trouvé le graphe sur le site. L’explication qui en est donnée est assez fabuleuse. Un changement de climat totalement soudain…

chercheur (#13), comme qui dirait la quantification du climat. Le climat ferait des sauts quantiques, avec des températures permises et d’autres non.

Amusant.

Quand une étude locale (en région Limousine) « Y’a plus d’saisons », aux éditions Verso, en 1992 de Vincent Cailliez montre un léger refroidissement des températures entre 1890 et 1990, c’est qu’il y a un problème avec les données…

En effet, cela ne colle pas avec le reste du monde qui se réchauffe dangereusement sur la même période, hein ?!

Pourtant, cette baisse des températures peut s’expliquer par la multiplication par quatre de la superficie des surfaces boisées en un siècle dans la région limousine, mais ce n’est là qu’une hypothèse…

Donc, la technique des « experts » consiste à chercher d’autres mesures, « d’enrichir » la base de données, d’en supprimer certaines et d’en garder d’autres…

Tiens donc, c’est pas possible qu’il ait fait chaud dans le Limousin entre 1926-1934, comme aux USA où l’année la plus chaude est justement 1934 ?

Heureusement que le CCROM, le Comité Consultatif des Réseaux d’Observations Météorologiques, veille pour rétablir la vérité !

C’est ce que l’on peut lire sur un document PDF intitulé « les séries de référence et les longues séries de données météorologiques » facilement trouvable sur votre moteur de recherche préféré…

Faut-il faire confiance aveuglément aux chercheurs de Météo France, dans leur méthodologie, leurs homogénéisations et leurs résultats, ou bien des contre-expertise seraient-elles nécessaires au vue des enjeux économiques et sociaux ?

Abitbol (#15),

Des contre-expertises sont non seulement nécessaires, mais aussi urgentes. Les coûts, actuel et avenir, de cette « lutte » contre le RCA sont énormes. En plus, et ce n’est pas le moins grave, cette histoire fait perdre toute crédibilité à la science. J’ajouterais aussi une perte dramatique de l’esprit critique d’une majorité de la population, dont les jeunes. On assiste à un endoctrinement de grande envergure.

Nicias (#10),

Un courrier de MF m’a dit ceci :

Cela suggère qu’il n’y a pas d’homogénéisation après 1947.

Ben (#17),

« Cela suggère qu’il n’y a pas d’homogénéisation après 1947. »

Pour l’instant, peut être… parce que :

Quelqu’un sait-il quand l’usage des thermomètres à minimum et à maximum a été généralisé en France, ou au moins dans les 30 stations servant de référence pour nous dire à quel point ça chauffe ? Leur invention est ancienne, mais quid de leur usage massif ?

Évidemment, la question est valable pour toutes les stations du monde. Je suppose que vous voyez où je veux en venir. Il y avait récemment ici des échanges concernant les heures de survenue des Tmin et Tmax dans le cycle de 24 heures. Avec un double thermomètre à minimum et maximum, pas de problème pour relever les bonnes valeurs. Mais quid de l’instituteur ou autre qui par deux fois quotidiennement relevait (relève encore ?) à heure fixe la température sur un thermomètre ordinaire ? Même en laissant de côté les différences d’évaluation entre observateurs, on peut s’interroger, on doit s’interroger sur la valeur des Tmin et Tmax relevées à heures fixes. Dans un bouquin sur les tempêtes, un ingénieur météo écrit, parlant de la pression et de la force du vent : « Sur la période 1875-1950, on ne dispose que de deux observations par jour (6h et 18h ou 7h et 18 h) ». Ces horaires sont aussi ceux des relevés de température.

Quelques exemples pour la ville de Niort. Pour la première, c’est parfait, Tmin et Tmax ont lieu quand on faisait les relevés. Mais dans bien des cas, il n’en va pas de même, loin s’en faut parfois :

C’est exemple sont d’une grande banalité, ils sont tous récents et je suis allé à la pêche à m’en remettant au hasard, en (largement) moins de deux minutes.

Comment comparer rigoureusement les moyennes quotidiennes ou encore les Tmin et Tmax actuelles avec les valeurs (les plus) anciennes dans ces conditions ? Est-il seulement possible d’apporter une correction, sans aucun moyen d’approcher le profil des températures quotidiennes ? La réponse est dans la question.

Si réchauffement il y a eu, prétendre le quantifier à la décimale près en affirmant que c’est du solide, c’est particulièrement malhonnête. Mais qui en doute encore ?…

Ben (#17),

Probablement à tort. La comparaison avec les données suisses est intéressante. On peut constater une parenté prononcée, en particulier à partir de 1950, avec les données homogénéisées helvétiques. Une discontinuité autour de 1947 est également apparente.

Cela dit, aucune de ces courbes ne représente ce qui est prétendu, soit, l’évolution des températures régionales. Les thermomètres des stations ne sont pas des instruments adaptés pour capter l’évolution à long terme. Les données satellitaires ainsi qu’un certain nombre de proxies font beaucoup mieux.

Hacène (#19),

Pour la France, je ne sais pas mais d’une manière générale ces problèmes sont connus et traités. L’Autriche, par exemple, avait un système de relevés horaires et est passée au min/max en pratiquant l’ajustement des données anciennes (sauf erreur, voir Auer et al 2001). Même avec les min/max, il y a des différences qui peuvent être importantes selon l’heure de relevé, c’est toute la polémique TOBS aux US.

phi (#20),

Encore un graphique intéressant qui montre la manipulation des données avec les homogénéisations.

Quand on regarde l’évolution de la série brute, elle semble parfaitement compatible avec l’effet ilot de chaleur qui progresse depuis un siècle.

Par contre l’évolution de la série homogénéisée montre qu’ils ont baissé légèrement les températures anciennes et fortement augmenté les températures depuis 1975. Quels sont les motifs de ces homogénéisations qui sont à l’inverse de ce qui aurait du être réalisé pour prendre en compte l’effet des ilots de chaleur.

chercheur (#22),

Le brusque changement de régime de l’ENSO en 1975 est sans doute à mettre en relation avec le changement brusque de la tendance de la temp globale à partir de la même date.

chercheur (#22),

Les séries de températures brutes contiennent effectivement divers caractères qui n’ont rien à voir avec le climat. Ce sont pour la plus grande partie des influences liées à la station elle-même et à l’urbanisation des environs. On peut en distinguer deux catégories :

1. Les effets non climatiques à caractère plus ou moins continu. Ils sont très difficiles voir impossibles à repérer et donc à corriger; les offices nationaux n’essayent même pas. Cause typique : l’effet d’îlot de réchauffement urbain.

2. Les discontinuités non climatiques. Aisément repérables et quantifiables. Pratiquement, c’est leur correction que l’on nomme homogénéisation. Les causes peuvent être diverses mais on constate que ces discontinuités sont préférentiellement orientée vers les bas et liées à des déplacements d’instruments. L’explication est très simple et naturelle : un opérateur cherchera pour un nouvel emplacement de préférence un endroit peu perturbé par l’environnement. En moyenne, on peut donc dire que les discontinuités sont gênantes pour les comparaisons inter-annuelles mais qu’elles constituent également des corrections partielles. D’un point de vue climatique, il ne faudrait évidemment pas homogénéiser.

phi (#21),

Connus, certes, mais traités… Comment ? En 1904, le 13 janvier, le brave M. Duchemin de Trifouilly-les-Oies a fait son relevé à 7 h 00, comme d’habitude (sauf eut-être le 1er janvier), et a retranscrit 6° C. Et puis ? C’était le minimum du jour ? C’était plutôt 4,8° C vers 4 h 40 ? 5,6° C à 8h20, voire 0° C à 23 h 45 ? On corrige comment ? Sur quelle(s) base(s) qui ne soient pas bidon ?

Question que je me pose depuis longtemps en ce qui concerne les relevés horaires de température, comment procède t-on lors des passages à l’heure d’été ou d’hiver? On relève les températures à une heure fixe en TU?

Hacène (#25),

Pour Trifouilly-les-Oies, je n’en sais fichtre rien. Dans les cas où cela est traité, la validité n’est que statistique et basée sur des courbes journalières moyennes. Tant que l’on dispose d’un certain nombre de stations et que l’on s’intéresse aux tendances à long terme, je suppose qu’on doit pouvoir s’en tirer. Cela dit, c’est effectivement une approximation de plus. Comme je l’ai dit plus haut, de toute façon, les thermomètres des stations ne sont pas des instruments adaptés à la mesure de l’évolution des températures sur le long terme.

mathurine (#26),

On peut supposer que cela est pris en compte. En principe, on devrait même utiliser l’heure solaire vraie ce qui complique passablement l’exercice. Cela dit, c’est aussi le genre de détail qu’on oublie facilement dans les traitements massifs et complexes.

phi (#27),

J’entends bien, mais ces « courbes journalières moyennes », quelle valeur ont-elles pour les périodes anciennes ? Si on les élabore avec rigueur pour un certain nombre d’années récentes, en confrontant les données obtenues automatiquement toutes les 10 mn par exemple avec celles de deux heures fixes (7h et 18h, par ex.), et qu’on s’en sert pour corriger une période ancienne, c’est qu’on postule implicitement qu’il y a une équivalence entre les deux périodes quant à la fréquence des différents types de temps. C’est loin d’être évident.

Hacène (#29),

Oui, sans doute avez-vous raison. Mon impression est simplement que ce problème particulier est traité au mieux. Je suis plus intrigué par les ajustements TOBS aux US, pas tellement par le principe mais plutôt par l’évolution tout à fait surprenante des heures de relevés au XXème siècle.

Ci-joint un lien intéressant vers un article du n°67 de la revue La Météorologie au sujet de la reconstitution des températures mensuelles en région parisienne de 1676 à 2008. Je ne l’ai pas encore lu et je ne sais pas si on y trouve une réponse sur la question liée à la mesure des Tmin et Tmax, mais je cite cet extrait du résumé de cet article qui corrobore le constat effectué par Courtillot et par l’observatoire savoyard du changement climatique sur le brusque réchauffement constaté à partir de 1988:

C’est à dire qu’avant 1988, il y a des fluctuations mais pas de tendance nette au réchauffement. C’est effectivement assez clair sur les deux graphiques ci-dessous extraits de cet article. Ceci dit, je trouve que le graphique de MF sur les Tmoyennes annuelles depuis 1900 donne un peu la même impression. Fluctuations sans tendance nette jusque 1988, puis brutale succession d’années « chaudes » ensuite avec de rares années « fraiches ».

Tiens, encore un mois record pour la NOAA.

cf (#32),

Tiens cf , c’est bien caille folle qui s’étonne des stats de la NOAA

la saga climatique

reprise de la « saison » températures

http://www.drroyspencer.com/20.....on-record/

gardons l’oeil sur la suite chez les kiwis,cela pourrait devenir intéressant, leur gouvernement semble avoir viré de bord?

phi (#24),

Un des objectifs de l’homogénéisation est bien de prendre en compte les effets de l’urbanisation.

http://geografie.ubbcluj.ro:80.....a_2008.pdf

Bob (#23),

Les températures annuelles ne semblent pas corrélées aux ENSO annuelles.

Un exemple qui montre bien que l’homogénéisation des données ne se fait qu’à sens unique… Les statisticiens seront peut être intéressés :

https://hal.archives-ouvertes.fr/file/index/docid/589931/filename/Article_cahiers_nantais.pdf

chercheur (#35),

Certains peuvent le croire et l’écrire mais ce papier ne démontre rien à ce sujet.

phi (#38),

Ah bon? Voici pourtant ce qui y est écrit.

chercheur (#39),

« …des ruptures attribuables à des modifications des conditions de mesure… »

C’est exactement ce que j’expliquais en #24. Seuls les sauts brusques sont pris en compte. En réalité, les homogénéisations ne corrigent pas les effets de l’urbanisation mais au contraire annulent les corrections que constituent les changements de sites et autres opérations de maintenance. L’effet de l’urbanisation a un caractère trop diffus pour être directement repérable.

De Moisselin et al. 2002 :

Hug (#7), chercheur (#12), ce changement brusque du climat européen vers 1986 (que je nomme affectueusement effet Tchernobyl) est connu depuis longtemps ici, cf un article de Skyfall il y a 7 ans (!) http://www.skyfall.fr/?p=166

C’est même l’argument principal des papiers de Courtillot et Le Mouël sur le sujet. Bref, c’est un phénomène qu’un simple observateur est capable de remarquer mais que la FARCE (la fraternité des alarmistes du réchauffement exagéré), MF en premier a complètement occulté, voire travesti pour perpétuer sa propagande anti-CO2, une preuve de plus de l’attaque systématique de la pseudo-science climatique contre la science et la raison.

miniTAX (#42)

On est bien d’accord, j’avais bien mentionné Courtillot dans mon post n°7.

Comme les skyfallers d’aujourd’hui ne sont pas forcément tous les mêmes que ceux de 2007, il n’est pas inutile de rappeler ce phénomène de temps à autres.

Hacène (#29),

Ces “courbes journalières moyennes” n’existent PAS pour les périodes anciennes. Avant les capteurs MMTS dans les années 80, qui ont leurs propres problèmes et qui sont loin d’être généralisés (essayez de trouver une station climatologique qui en soit équipée en Afrique, bon courage), cette notion de courbe journalière n’a aucun sens (sauf peut-être dans une station ou deux sur toute la planète avec un enregistreur à papier).

Les seules données qu’il y a sur les séries longues, c’est Tmin, Tmax (par des capteurs à butée, qu’il faut secouer tous les jours) et éventuellement Tobs au moment du relevé. C’est tout.

Eh oui, elle est aussi mauvaise que ça la « science » climatologique et tout le blabla d’enfumage de Phi & co pour noyer le poisson et relativiser sa médiocrité n’y changera rien. Un cochon, vous avez beau lui coller une belle robe et un beau rouge à lèvre, ça restera un cochon.

miniTAX (#44),

Nous sommes bien d’accord. C’est pour cela que j’interrogeais (pour le moins) la pertinence de plaquer de telles courbes obtenues à partir d’une période récente à des périodes anciennes.

D’accord aussi pour le reste.

J’en reviens à ma question initiale : depuis quand, au moins en France, utilise-t-on de manière systématique des « capteurs à butée », autrement dit des thermomètres à minimum et à maximum (dont la conception est ancienne) ? La question vaut particulièrement pour les 30 stations retenues par Météo-France afin de construire sa « température en France ».

chercheur (#36),

Les températures "annuelles" sont des moyennes et idem pour les ENSO"annuelles". Il faut éviter de faire des corrélations entre moyennes lissées.

Par contres, si on superpose (ma superposition n'est pas parfaite) les variations de températures mensuelles avec les ENSO mensuelles, voici ce que ça donne. En haut les temps HadCRUT4, UAH, GISS et RSS. En bas l'ENSO per la NOAA.

Si ce n'est pas corrélé, ça, j'en perds mon latin (et j'ai 6 ans de latin) .

Bob (#46),

Il y a un billet sur PU à ce sujet, il est à peu près au milieu de cette page

Hug (#47),

Merci, Hug. En effet. Mais il date un peu. Le graphique ci-dessus est d'aujourd'hui

Hug (#47),

(on se comprend, n’est-ce pas Bob ?)

(on se comprend, n’est-ce pas Bob ?)

mais puisque l’on vous dit que tout ça est parfaitement établi, bon, il y a bien de temps à autre quelques petites anomalies,comme ici

http://notalotofpeopleknowthat.wordpress.com/

ou comme en Australie,voir ici

http://jennifermarohasy.com/

faut l’avoir lu pour le croire, quand le BOM, qui n’a évidemment aucun argument à faire valoir, déclare qu’ils appliquent les méthodes utilisées au niveau mondial,

Un des arguments souvent entendu est qu’il n’est pas possible que des milliers de scientifiques de par le monde participeraient à une sorte de complot,pour faire avancer l’agenda du club de la poele à frire et en effet cela paraît invraisemblable.

Mais je commence à avoir de sérieux doutes